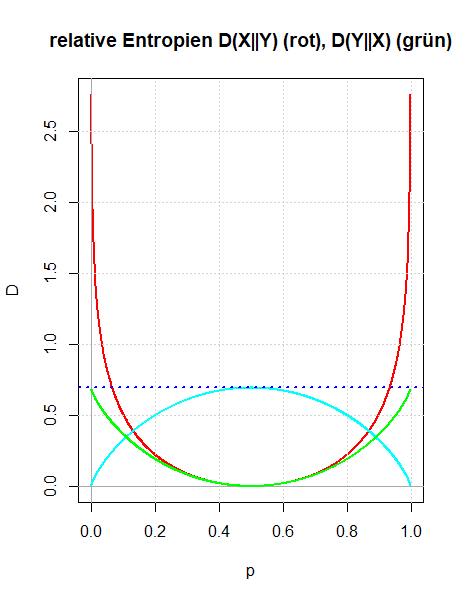

Es werden zwei Zugänge gezeigt, wie man die relative Entropie motivieren kann: Entweder als Verallgemeinerung der gegenseitigen Information oder indem man die Überlegungen Boltzmanns zur Definition der Entropie in dem Sinn verallgemeinert, dass man die Voraussetzung der Gleichwahrscheinlichkeit der Mikrozustände aufgibt. Die Bedeutung der relativen Entropie als einer Größe, die quantifiziert, wie unterschiedlich zwei Wahrscheinlichkeitsverteilungen sind, wird durch den zweiten Zugang besser verständlich.

Akzeptiert man die Entropie als eine Kenngröße einer Wahrscheinlichkeitsverteilung, die die Ungewissheit über den Ausgang eines Zufallsexperimentes beschreibt, so wird man fordern, dass sich bei unabhängigen Zufallsexperimenten die Entropien addieren.

Um diese Aussage schärfer formulieren zu können, wird die gemeinsame Entropie H(X, Y) von zwei Zufallsvariablen eingeführt.

Es wird gezeigt, dass die übliche Definition der Entropie die Additivitätseigenschaft bei unabhängigen Zufallsvariablen X und Y besitzt.

Die Zufallsexperimente Ziehen mit Zurücklegen beziehungsweise Ziehen ohne Zurücklegen werden umformuliert in eine Zufallsbewegung auf einem Gitter. Dadurch lassen sich viele Herleitungen besser veranschaulichen. Gezeigt wird dies hier für die Verteilungen der Zufallsvariablen, die die Anzahl der Treffer oder die Wartezeit bis zu einem bestimmten Treffer beschreiben.

Es werden die Wartezeitprobleme bei den beiden Zufallsexperimenten Ziehen mit Zurücklegen beziehungsweise Ziehen ohne Zurücklegen untersucht.

Bei diesen Zufallsexperimenten befinden sich in einer Urne Treffer und Nieten. Mit Wartezeitproblem ist gemeint, dass man eine Zufallsvariable definiert, die angibt nach wie vielen Zügen der r-te Treffer aus der Urne entnommen wird. Zur Vorbereitung werden die Zusammenhänge zwischen Binomialverteilung, geometrischer Verteilung und hyper-geometrischer Verteilung gezeigt.

Die geometrische Verteilung kann als Verteilung von Wartezeiten aufgefasst werden, wenn man einen Münzwurf solange wiederholt bis der erste Treffer eintritt: man berechnet die Wahrscheinlichkeiten der Anzahl der nötigen Würfe. Man kann dieses Wartezeitproblem verallgemeinern, indem man nicht bis zum ersten sondern bis zum r-ten Treffer wartet. Die Verteilung dieser Wartezeiten wird berechnet und die Eigenschaften der dabei entstehenden Verteilung wird untersucht.

Die Definition der Entropie eines Wahrscheinlichkeitsmaßes oder einer Zufallsvariable wird an einfachen Beispielen erläutert. Es wird diskutiert, dass die Entropie kein Streuungsmaß ist (wie die Standardabweichung), sondern die Ungewissheit (oder Unbestimmtheit) des Ausgangs eines Zufallsexperimentes beschreibt.

Die Funktion sample() wird verwendet, um Stichproben zu erzeugen. Sie lässt sich so konfigurieren, dass man die Wahrscheinlichkeitsverteilungen von beliebigen selbstdefinierten diskreten Zufallsvariablen einsetzen kann. Zudem kann man das Ziehen mit beziehungsweise ohne Zurücklegen realisieren.